2022. 3. 31. 15:52ㆍNaver BoostCamp AI Tech 3기

Abstract

이번 논문에서는 BART를 소개한다. BART는 seq2seq model을 pre-training시키는 denoising autoencoder이다. BART는 (1) 임의의 noising function으로 텍스트를 손상시키고, (2) original 텍스트를 재구축하기 위한 model을 학습한다. BART는 standard Transformer-based machine translation 아키텍처를 사용하며, 이 아키텍처는 간단함에도 불구하고, BERT와 GPT 및 다른 pre-training 방법들을 일반화 시킨 것으로 보여질 수 있다. BART 연구팀은 수많은 noising 방법들을 평가하며, 그 결과 제일 좋은 성능을 보인 것은 original 문장의 순서를 랜덤하게 shuffle하고 새로운 in-filling하는 방법(text의 특정 범위를 단일 mask 토큰으로 교체함)을 둘 다 사용하는 것이다. BART는 text generation을 fine-tuning할 때 특히 효율적이지만, comprehension task에도 역시 잘 동작한다. 이 모델은 GULE와 SQuAD 훈련 데이터를 기준으로 RoBERTa의 성능과 맞먹으며, abstractive dialogue, question answering, summarization task에서는 새로운 sota를 달성한다. BART는 또한 machine translation을 위한 back-translation system의 성능보다 1.1 BLEU 스코어를 더 달성하며, 여기서 pre-training은 target language에 대해서만 진행했다. 또한 BART framework 내의 다른 pre-training 방법들에 대한 ablation experiment에 대한 결과를 보고하며, 이는 end-task 성능에 어떤 요인이 가장 영향을 미치는지 비교하기 위함이다.

1 Introduction

Self-supervised 방법은 NLP task에서 전반적으로 성공을 거두었는데, 가장 좋은 방법은 masked language model을 변형한 것으로, 그 중에서도 랜덤하게 mask된 단어들을 재구축하는 denoising autoencoder들이다.

이번 논문에서는 Bidirectional and Auto-Regressive Transformers를 포함한 모델을 pre-training시키는, BART에 대해 소개한다. BART는 Figure 1에서와 같이 BERT, GPT, 그 외 많은 pre-training 방법들을 일반화한 방법이라고 볼 수 있다.

이 setup의 주요 장점은 바로 noising flexibility로, 임의의 transformation이 original text에 적용될 수 있는데, 문장의 길이를 변화하는 것도 가능하다. Noising 방법들에 대한 여러 실험 끝에, 제일 좋은 성능을 보인 것은 original 문장의 순서를 랜덤하게 shuffle하고 새로운 in-filling하는 방법(text의 특정 범위를 단일 mask 토큰으로 교체함)을 둘 다 사용하는 것이다. 이 접근법은 BERT 내의 word masking과 next sentence prediction을 일반화 시키는데, 이는 모델이 전반적인 문장 길이를 추론하고 input에 대한 longer-range의 transformation을 만들도록 함으로써 성립한다.

BART는 또한 fine-tuning에 대한 새로운 사고방식을 열었다. 연구팀은 machine translation에 대한 새로운 방법을 제시하는데, 바로 BART 모델이 추가적인 transformer layers 위에 쌓이는 것이다. 이 layer들은 foreign language를 BART를 통과하여서 noised English로 번역하도록 훈련하고, 그에 의하여 BART를 pre-trained target-side language model로써 사용하는 것이다. 이 방법은 WMT Romanian-English benchmark에서 강력한 back-translation MT baseline으로 1.1 BLEU 스코어를 달성한다.

이 현상들을 더 잘 이해하기 위해서, ablation analysis에 대한 결과도 보고할 것이다. 연구팀은 BART가 고려하는 task들 전체에서 꾸준히 강한 성능을 낸다는 것을 선보일 것이다.

2 Model

BART는 손상된 document를 original document로 mapping하는 denoising autoencoder이다. BART는 손상된 text에 대한 bidirectional encoder와 left-to-right autoregressive decoder로 구성되는 sequence-to-sequence 모델이다. Pre-training을 위해서, original document의 negative log-likelihood를 최적화한다.

2.1 Architecture

BART는 standard sequence-to-sequence Transformer 아키텍처를 사용하는데, 다만 뒤에 GPT가 따라 붙으며, ReLU 대신 GeLU를 사용하며, parameter는 정규분포 N(0, 0.02)에서 초기화한다. Base model은 encoder-decoder layer를 6개, large model은 12개를 각각 사용한다. 이 아키텍처는 BERT에서와 비슷하지만 몇 가지 차이점이 존재하는데, (1) decoder의 각 layer는 추가적으로 encoder의 final hidden layer와 cross-attention을 진행하며, (2) BERT에서는 사용된 word-prediction 이전의 feed-forward network를 BART에서는 사용하지 않는다. 정리하면, BART는 동일 사이즈의 BERT 모델보다 약 10% 더 많은 parameter를 가진다.

2.2 Pre-training BART

BART는 document를 손상시키고 reconstruction loss를 최적화하는 식으로 훈련되는데, 여기서 loss는 decoder의 output과 original document 사이의 cross-entropy이다. 기존의 denoising autoencoder들과는 다르게, BART는 어떠한 종류의 document 손상이라도 적용시킬 수 있다. 극단적인 경우로, source의 모든 정보가 없다 하더라도, BART는 language model과 동일한 것이다.

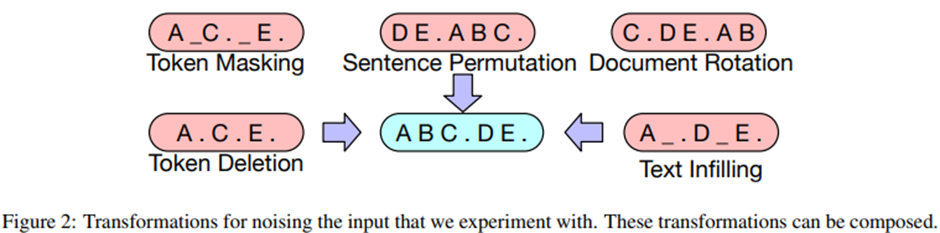

연구팀에서는 이전에 제안된 여러 transformation 및 새로운 transformation들을 가지고 실험하였는데, 더 큰 성능 향상을 낼 수 있는 다른 대체적인 transformation이 있을 거라고 생각한다. 실험한 transformation들은 Figure 2에 나타나 있다.

Token Masking

BERT와 동일하게 랜덤 token을 샘플링하고 [MASK]로 교체한다.

Token Deletion

랜덤 토큰들이 input으로부터 제거된다. Token masking과는 대조적으로, 모델은 어떤 position이 missing input인지 결정해야만 한다.

Text Infilling

많은 text span들이 샘플링 되며, span의 길이는 푸아송 분포(lambda = 3)에서 샘플링 된다. 각 span은 단일 [MASK] 토큰으로 교체된다. 0-length span은 [MASK] 토큰을 삽입하는 것과 같다. 이 Text infilling은 Span-BERT에서 영감을 받은 것인데, 기존 논문과는 다르게 푸아송 분포에서 길이를 샘플링 하며, 단일 [MASK] 토큰으로 교체하므로 모델이 원래 span의 길이까지 예측하게 훈련한다.

Sentence Permutation

Document를 마침표를 기준으로 하여 문장들로 나누고, 이 문장들은 랜덤한 순서로 섞이게 된다.

Document Rotation

1개의 토큰이 균일 확률로 랜덤하게 선택되며, document가 그 선택된 토큰으로 document가 시작되도록 rotate된다. 이 task는 모델이 document의 시작점이 어디인지 찾도록 훈련하는 것이다.

3 Fine-tuning BART

BART에 의해 생성된 representation들은 downstream application에서 여러 방법으로 사용될 수 있다.

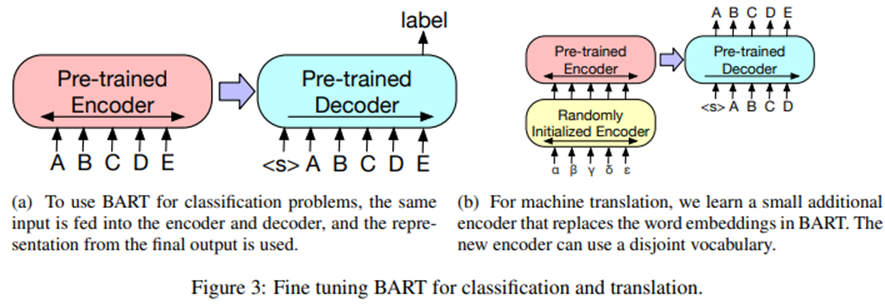

3.1 Sequence Classification Tasks

Sequence classification task를 위해서는, encoder와 decoder에 같은 input을 넣고, final decoder token의 final hidden state를 새로운 multi-class linear classifier에 투입하여 분류한다. 이 방법은 BERT의 [CLS] 토큰과 관련이 있지만, 다른 점은 BART에서는 decoder 맨 끝에 추가적인 token을 넣어서 이것으로 전체 input에 대한 decoder 내의 state들과 attend할 수 있게 된다. 해당 내용은 Figure 3a에 나타나 있다.

3.2 Token Classification Tasks

SQuAD의 answer endpoint classification과 같은 token classification task들에서는, encoder와 decoder에 완전한 document를 넣고, decoder의 top hidden state를 각 단어에 대한 representation으로 사용한다. 이 representation은 token을 분류하는데 사용된다.

3.3 Sequence Generation Tasks

BART는 autoregressive decoder를 가지므로, abstractive question answering 및 summarization과 같은 sequence generation task들에 대해 직접적으로 fine-tuning 할 수 있다. 이 2개의 task에서, information은 input으로부터 복사되지만 변형되는데, 이는 denoising pre-training objective와 꽤 유사하다. 여기서, encoder의 input은 input sequence이고, decoder는 output을 autoregressively하게 생성해낸다.

3.4 Machine Translation

또한 BART를 영어로 번역하는 machine translation decoder들의 성능 향상을 위해 사용할 수 있다. 이전 연구들에서는 decoder에서 pre-trained language model을 사용하여 얻는 성능은 한계가 있다고 하였는데, 이번 논문에서는 전체 BART 모델(encoder, decoder 둘 다)을 machine translation을 위한 단일 pre-trained decoder로써 사용하는 것이 가능하다는 것을 보일 것이다. 단, bitext에서 학습된 새로운 encoder parameter들을 추가시킨다. 해당 내용은 Figure 3b에 나타나 있다.

더 구체적으로, BART의 encoder embedding layer를 새로 랜덤하게 초기화된 encoder로 변경한다. 모델은 end-to-end로 학습될 것이고, 이는 새 encoder가 foreign word들을 input으로 mapping하도록 학습하며, 이로써 BART가 영어로 de-noise할 수 있게 된다. 새 encoder는 original BART 모델과 분리된 vocabulary를 사용할 수 있다.

여기서 source encoder를 두 단계로 나누어 훈련하는데, 둘 다 BART 모델의 output으로부터의 cross-entropy loss를 backpropagate하는 것이다. 1단계에서는, 대부분의 BART parameter들을 freeze하고 랜덤 초기화된 source encoder와 BART의 positional embedding, 그리고 BART encoder의 첫 번째 layer의 self-attention input projection matrix만 update한다. 2단계에서는, 모든 모델의 parameter들을 작은 iteration만큼 훈련시킨다.

4 Comparing Pre-training Objectives

BART는 이전 연구들에서 보다 pre-training 동안 훨씬 더 많은 noising 방법들을 지원한다. 이 옵션들을 base-size 모델(6 encoder layers, 6 decoder layers, hidden size = 768)을 사용하여 평가하며, 여러 task에서 평가한다.

4.1 Comparison Objectives

그러나, training data의 차이, resources의 차이, 모델 간 아키텍처의 차이점, fine-tuning 과정의 차이로 인하여 공정한 비교가 어렵다. 그래서, 연구팀에서는 최근에 discriminative 및 generation task를 위해 제안된 강력한 pre-training 방법들을 재구현한다. 그렇지만, 여기에 학습률 및 layer normalization에 약간의 변화를 주어 성능 향상이 되도록 하였다. 참고를 위해서, 이렇게 구현한 것과 BERT에서 발표된 것을 비교할 것이다. 이제부터, 다음 방법들에 대해 비교를 할 것이다.

Language Model

GPT와 유사하게, left-to-right Transformer language model을 훈련시킨다. 이 모델은 BART의 decoder와 동일하지만, cross-attention은 없다.

Permuted Language Model

XLNet을 기초로 하여, 토큰들의 1/6을 샘플링하고 이들을 랜덤한 순서로 autoregressively하게 생성해낸다. 다른 모델과의 일치를 위해, XLNET에서의 relative positional embedding 또는 attention을 구현하지는 않는다.

Masked Language Model

BERT와 동일하게, 15%의 토큰을 [MASK]로 변경하고 모델이 각각 독립적인 original 토큰들을 예측하도록 훈련한다.

Multitask Masked Language Model

UniLM에서와 같이, Masked Language Model을 추가적인 self-attention mask들로 훈련시킨다. Self-attention mask들은 다음 중 하나로 선택된다. (1/6 left-to-right, 1/6 right-to-left, 1/3 unmasked, 1/3 중 첫 50%는 unmasked, 그리고 나머지는 left-to-right mask)

Masked Seq-to-Seq

MASS에 영감을 받아, 50%의 토큰의 span을 mask하며, sequence to sequence 모델이 masked token들을 예측하도록 한다.

Permuted LM, Masked LM, 그리고 Multitask Masked LM에서는, two-stream attention을 사용하는데, 이는 효율적으로 sequence의 output part의 likelihood를 계산하기 위함이다. (word를 left-to-right로 예측하기 위해 diagonal(대각) self-attention mask를 사용한다.)

연구팀은 다음 2가지에 대해 실험한다. (1) task를 standard한 sequence-to-sequence problem으로 취급하고, 여기서 source input은 encoder로 들어가고 target은 decoder output이라 할 수 있다. 또는 (2) source를 decoder 내의 target에 대한 prefix로 추가하고, loss는 오직 sequence에서 target 부분에만 적용된다. 실험 결과, (1)은 BART 모델들에 더 잘 동작하고, (2)는 다른 모델들에 대해 더 잘 동작한다는 것을 확인했다.

이 BART 모델들의 fine-tuning objective를 모델링하는 능력에 대해 직접적으로 비교하기 위해, Table 1에 perplexity를 보고한다.

4.2 Tasks

SQuAD

Answer들은 주어진 document context로부터 추출된 text span이며, BERT와 비슷하게 question 및 context를 결합하여 BART의 encoder로 입력으로 넣으며, 추가적으로 decoder에도 넣어준다. 이 모델은 각 token의 start 및 end indices를 예측하기 위한 classifier들을 포함한다.

MNLI

한 문장이 다른 문장을 entail하는 지 예측하는 bitext classification으로, fine-tuned 모델은 2개의 문장을 EOS token으로 결합하며, 이들을 BART encoder 및 decoder에 모두 넣어준다. BERT와는 대조적으로, EOS token의 representation이 sentence relation을 분류하는 데에 사용된다.

ELI5

긴 형태의 abstractive question answering dataset으로, 모델은 question과 supporting document을 엮은 sequence가 주어지면 answer를 생성하게 된다.

XSum

매우 abstractive한 summaries들이 있는 news summarization dataset이다.

ConvAI2

Dialogue response generation task로, context 및 persona(페르소나?)가 주어진다.

CNN/DM

역시 news summarization dataset으로, 여기의 summaries들은 source sentence들과 꽤 관련이 깊다.

4.3 Results

결과는 Table 1에 나타나 있다. 다음과 같은 트렌드가 명확한 것 같다.

Performance of pre-training methods varies significantly across tasks

Pre-training의 방법들의 효율성은 task에 매우 의존적이다. 예를 들어, 단일 language model이 가장 높은 ELI5 성능을 달성하지만, SQUAD는 최악의 결과로 나타났다.

Token masking is crucial

Document를 rotate하거나 permute하는 것에 기반한 pre-training objective들은 단독으로 쓰이면 성능이 낮다. 성공적인 방법에서는 token deletion 또는 token masking 또는 self-attention mask를 같이 사용한다. 이 중 deletion이 generation task들에서의 masking을 성능에서 압도한다.

Left-to-right pre-training improves generation

Masked Language Model과 Permuted Language Model은 generation에서 성능이 다른 것들보다 조금 더 낮으며, 이 둘은 유일하게 pre-training 동안 left-to-right auto-regressive language modelling이 포함되지 않는 모델이다.

Bidirectional encoders are crucial for SQuAD

이전 연구에서 알려졌듯이, left-to-right decoder만 사용하는 것은 SQuAD에서 성능이 낮으며, 이는 미래의 context가 classification 결정에서 중요하기 때문이다. 그러나, BART는 오직 절반 정도의 bidirectional layer만으로 비슷한 성능을 달성한다.

The pre-training objective is not the only important factor

연구팀의 Permuted Language Model은 XLNET보다 성능이 낮다. 이 차이점은 아마 다른 아키텍처 적인 개선 사항을 포함하지 않기 때문일 것으로, relative-position embedding 또는 segment-level recurrence 등이 있을 것이다.

Pure language models perform best on ELI5

ELI5 dataset은 outlier로, 다른 task들보다 훨씬 더 높은 perplexities가 있고, 유일하게 다른 모델들이 BART를 성능에서 압도하는 generation task이다. Pure language model이 제일 성능이 좋으며, 이는 BART가 output이 input에 의해 크게 제약받지 않는 경우에는 덜 효율적이라는 것을 제시한다.

BART achieves the most consistently strong performance

ELI5를 제외하고는, text-infilling을 사용하는 BART 모델들은 모든 task에 대해 잘 동작한다.

5 Large-scale Pre-training Experiments

최근 연구에서는 downstream 성능이 pre-training시 batch size를 크게 하고 corpora를 더 큰 것을 사용하면 놀라운 성능으로 증가한다는 것을 보였다. 이 방식에서 BART가 어떻게 동작하는 지 테스트하기 위해서, 그리고 downstream task에 대한 유용한 모델을 만들기 위해서, BART를 RoBERTa 모델과 같은 규모로 훈련시켰다.

5.1 Experimental Setup

Encoder와 decoder의 각각의 12개의 layer로 hidden size는 1024로 하여 large model을 pre-train한다. RoBERTa를 따라서, batch size를 8000, 총 500000 step 훈련시킨다. document들은 GPT-2와 동일한 byte-pair encoding으로 tokenized된다. Section 4에서의 결과에 근거하여, text infilling과 sentence permutation을 같이 사용한다. 각 document에서 30%의 token을 mask하며, 모든 문장을 permute한다. 비록 sentence permutation이 CNN/DM summarization dataset에서만 추가적인 성능 향상을 보였지만, 연구팀은 더 큰 pre-trained 모델들이 아마 이 task를 더 잘 학습할 것이라고 가정했다. 모델이 data에 더 잘 fit되도록 하기 위해서, 마지막 10%의 training step에서는 dropout을 disable하였다. Pre-training data는 news, 책, stories, web text로 160GB를 사용하였다.

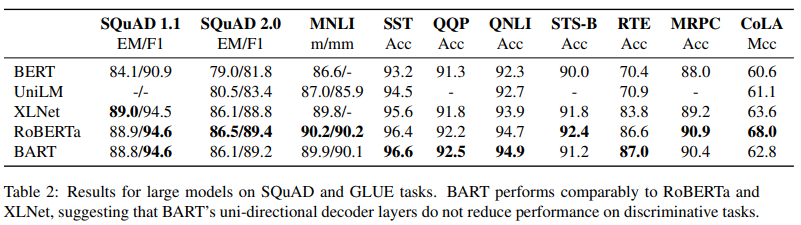

5.2 Discriminative Tasks

Table 2에서는 BART의 성능을 SQuAD 및 GLUE task들의 최신 접근법들과 비교하였다.

가장 직접적으로 비교 가능한 baseline은 RoBERTa로, 같은 resource로 pre-trained 되었고 objective는 다르다. 전반적으로, BART는 비슷하게 성능이 나오며, 대부분의 task에서 모델들과 아주 작은 차이들만 있었을 뿐이다. 이는 BART의 generation task에서의 성능 향상이 classification 성능을 희생한 결과가 아니라는 것을 시사한다.

5.3 Generation Tasks

또한 여러 text generation task들에 대해 실험하는데, BART는 standard한 sequence-to-sequence 모델로 fine-tuned 된다. Fine-tuning 시에는 label smoothed cross entropy loss를 사용하며, smoothing parameter는 0.1이다. Generation 동안에, beam size는 5이며 중복된 trigram은 제거하고, 모델을 validation set에 대해 최소 길이, 최대 길이, 길이 penalty를 부여하여 tune한다.

Summarization

summarization에서의 sota와 비교하기 위해서, 2개의 summarization dataset(CNN/DailyMail, XSum)에 대한 결과를 제시한다. 이 두 dataset은 서로 다른 특성을 가진다.

CNN/DailyMail에서의 summaries는 source sentence들을 닮는 경향이 있다. Extractive 모델들은 여기서 잘 동작하며, 첫 3개의 source sentence들의 baseline은 매우 competitive하다. 그럼에도 불구하고, BART는 현존하는 모든 연구에서의 성능을 압도한다.

이와 대조적으로, XSum은 매우 추상적이고, extractive 모델들의 성능이 낮다. BART는 이전의 가장 좋았던 연구의 성능을 압도하여, BERT를 끌어내리면서, 모든 ROUGE metrics에서 6.0 point 정도 앞선다.

Dialogue

연구팀에서는 CONVAI2에 대한 dialogue response generation을 평가하며, 여기서 agent는 이전 context와 textually-specified persona를 다 고려하여 대답을 생성해야만 한다. BART는 이전 연구들의 성능을 2개의 자동화된 metrics에서 압도한다.

Abstractive QA

최근에 제안된 ELI5 dataset을 모델의 long free-form answer를 생성하는 능력을 테스트하기 위해 사용한다. BART가 역시 이전의 최고 성능을 압도하지만, dataset 자체가 어려운 편이다. (answer가 question에서 weakly하게 specified됨)

5.4 Translation

또한 WMT16 Romanian-English에 대해 성능을 평가하였고, back-translation data로 augment되었다. 루마니아어를 BART가 영어로 de-noise할 수 있는 representation으로 mapping하기 위해 6-layer transformer source encoder를 사용하며, 이는 Section 3.4에서 소개된 방식이다. 실험 결과는 Table 6에 나타나 있다.

연구팀은 이 결과를 Transformer-large setting의 baseline과 비교한다. Fixed BART와 Tuned BART의 성능을 다 제시한다. 각 행에서의 실험 모두 WMT16 Romanian-English dataset(with back-translation data)로 실험한다. Beam size는 5이며 length penalty의 alpha는 1이다. 예비 결과들에서는 back-translation data없이 BART 접근법이 덜 효율적이라는 것을 제시하였고, overfitting에 이르기 쉽다는 것을 제시하였다.

6 Qualitative Analysis

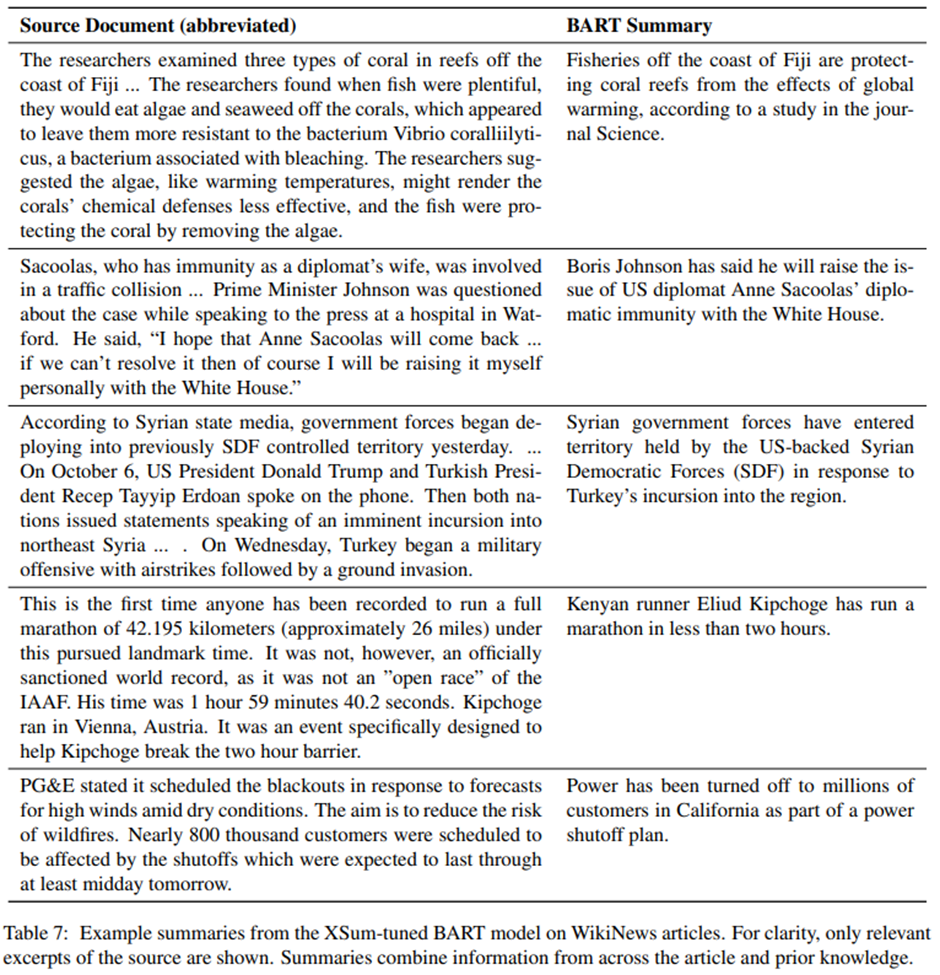

BART는 summarization metrics에서 큰 성능 향상을 보여주며, 이 BART의 성능을 이해하기 위해서, 연구팀에서는 BART의 generation들을 정성적으로 분석한다.

Table 7은 BART에 의해 생성된 summaries의 예시를 보여준다.

예시들은 WikiNews 기사들에서 가져온 것으로(pre-training corpus는 이미 생성한 이후), 이는 현재 모델의 training data에 존재하는 사건이 묘사될 가능성을 제거하기 위함이다. Summarizing 하기 전에 기사의 첫 문장을 제거하여, document의 쉬운 easy extractive summary 가능성을 제거한다.

모델의 output은 유창하고 문법적으로 영어였다. 그러나, 모델의 output은 또한 매우 추상적이며, input에서 phrase들이 거의 copy되지 않았다. 또한 output은 일반적이고 사실적으로 정확하며, input document에서 background knowledge와 함께 supporting evidence를 통합한다. 첫 예시에서는, 물고기가 지구 온난화로부터 암초를 보호하고 있다고 추론하는 것은 텍스트에서 간단한 추론을 필요로 한다. 그러나, 이 연구가 Science에 실렸다는 주장은 source 문장에서 뒷받침하지 못한다.

이 샘플들은 BART pre-training이 NLU와 Generation의 강한 combination을 학습했다는 것을 증명한다.

7 Related Work

Pre-training에 대한 초기 방법들은 language model에 기초하였는데, 혰는 오직 left-ward context만 모델링하였고, ELMo는 left-only와 right-only를 결합한 representation으로, 이 둘을 결합하여 pre-train 시키지는 않았다. GPT-2에서는 unsupervised multitask model처럼 동작할 수 있는 매우 큰 language model을 제시하였다.

BERT는 masked language modeling을 제시하였고, left context와 right context 사이의 interaction 학습을 pre-train하는 것을 가능하게 했다. 최근 연구에서는 훈련을 더 오래 하고, layer 간 parameter를 묶고, 그리고 단어 대신 span을 masking하는 식으로 매우 좋은 성능을 얻을 수 있음을 보였다. Prediction은 auto-regressively하게 만들어지지 않으며, generation task에서의 BERT의 효율성을 감소시킨다.

UniLM은 BERT를 mask들의 앙상블로 fine-tune하고, 이 중 몇몇은 leftward context만 허용된다. BART와 같이, 이는 UniLM이 generative 및 discriminative task들에 둘 다 사용될 수 있게 한다. 차이점은 UniLM의 prediction은 조건적으로 독립적이며, 반면 BART는 autoregressive하다는 것이다. BART는 pre-training과 generation task 사이의 mismatch를 줄이며, 왜냐하면 decoder가 항상 손상되지 않은 context로 훈련되기 때문이다.

MASS가 아마 BART와 가장 비슷한 모델일 것이다. Token의 연속적인 span이 mask되는 input sequence는 missing token을 구성하는 sequence로 mapping된다. MASS는 discriminative task에는 덜 효율적으로, 왜냐하면 token의 disjoint set(서로소 집합, 공통원소가 없음)이 encoder와 decoder로 들어가기 때문이다.

XL-Net은 BERT를 permuted한 순서에서 mask된 token들을 auto-regressively하게 예측함으로써 확장한다. 이 objective는 예측이 left 및 right context 모두에 영향을 받도록 한다. 이와 대조적으로, BART decoder는 pre-training 동안 left-to-right하게 동작하며, generation 동안에는 setting을 일치시키게 된다.

여러 논문에서 pre-trained representation을 machine translation 성능을 향상시키기 위해 사용하는 것을 연구하였다. 가장 성능 향상이 크게 왔던 방법은 source 및 target language에 대해 모두 pre-train하는 것이지만, 이는 해당 언어들 모두를 pre-training해야만 한다. 다른 연구에서는 encoder가 pre-trained representation을 사용하여 향상될 수 있음을 보였지만, decoder에서는 더 제한적이였다. 연구팀은 BART가 어떻게 machine translation decoder들을 향상시키기 위해 사용될 수 있는지 보였다.

8 Conclusions

연구팀에서는 BART를 소개하였다. 이 방법은 손상된 document들을 original document로 mapping하는 법을 학습한다. BART는 discriminative task에서는 RoBERTa와 비슷한 성능을 달성하며, 반면 많은 text generation task에서는 새로운 sota를 달성한다. 후속 연구에서는 pre-training을 위한 document 손상에 대한 새로운 방법을 찾아봐야 하며, 아마 구체적인 end-task에 따라 달라질 수 있다.

'Naver BoostCamp AI Tech 3기' 카테고리의 다른 글

| [MRC] 02. Extraction-based MRC (0) | 2022.04.26 |

|---|---|

| [MRC] 01. MRC Intro & Python Basics (0) | 2022.04.25 |

| KLUE: Korean Language Understanding Evaluation (0) | 2022.03.26 |

| RoBERTa: A Robustly Optimized BERT Pretraining Approach (0) | 2022.03.24 |

| Language Models are Unsupervised Multitask Learners (0) | 2022.03.14 |