2022. 3. 26. 23:56ㆍNaver BoostCamp AI Tech 3기

Abstract

KLUE benchmark에 대한 논문이다. 8가지 한국어 NLU task에 대한 모음이 KLUE이며, Topic Classification, Semantic Textual Similarity, Natural Language Inference, Named Entity Recognition, Relation Extraction, Dependency Parsing, Machine Reading Comprehension, Dialogue State Tracking 이렇게 8가지이다. 저작권을 지키면서 scratch에서 다양한 corpora를 써서 모든 task를 구축하였다. 또한 KLUE에 적합한 evaluation metric도 제공한다. Pre-trained 모델인 PLM, KLUE-BERT, KLUE-RoBERTa를 release한다. 먼저 이번 연구에서 발견한 점에 대해 말하자면, 첫 번째로는 가장 좋은 성능의 baseline은 KLUE-RoBERTa_LARGE였다. 두 번째로는 개인정보에 관한 걸 제거해도 성능 저하가 최소한으로 이루어졌다는 것이다. 마지막으로, BPE tokenization과 morpheme-level pre-tokenization을 함께 사용하는 것이 morpheme-level tagging, detection, generation의 task에서 효율적이라는 것이다. 더 자세한 내용은 다음 주소를 참고하면 된다.

KLUE Benchmark

klue-benchmark.com

1 Introduction

1.1 Summary

Baselines

첫 번째, Korean-specific language model이 전반적으로 multilingual model들의 성능을 압도한다.

두 번째, 사이즈를 조절 시, 각각 다른 모델들이 각각 다른 task에 제일 좋은 성능을 낸다. 이 중 KLUE-RE의 경우는 KLUE-RoBERTa가 제일 성능이 좋다.

세 번째, 모델의 사이즈를 크게함에 따라서, 결국은 KLUE-RoBERTa_LARGE가 KLUE-NER을 제외한 모든 task에서 다른 모델들의 성능을 압도하게 되었다.

마지막으로, 개인정보를 제거하는 것은 downstream task 성능에 큰 영향이 없었으며, morpheme-level에서의 tagging, detection, generation task들은 morpheme-based subword tokenization이 효율적이라는 것을 알아냈다.

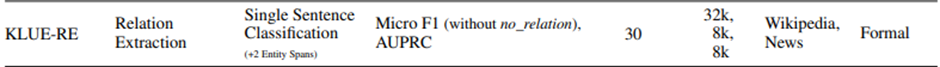

다음은 Table 1의 KLUE-RE에 관한 것이다.

3 KLUE Benchmark

3.5 Relation Extraction (RE)

관계 추출(RE)은 텍스트에서 entity pair간의 의미 관계를 밝히는 task이다. 이 관계는 subject entity (e_subj)와 object entity (e_obj)를 구성하는 entity pair 간에 정의된다.

관계 추출(RE)은 모델이 entity 간의 관계를 올바르게 이해하는 지를 평가하기 적합한 task이다. 이를 평가하기 위해, 대규모의 RE benchmark를 한국어 버전으로 구축하게 되었다.

연구팀에서는 관계 추출(RE)을 single sentence classification task로 공식화한다. 모델은 주어진 문장 내에서 2개의 entity간에 관계를 나타내는 predefined된 관계 class 중 1개를 선택한다. 다시 말해서, RE 모델은 entity pair (e_subj, e_obj)의 적절한 관계 r을 문장 s 안에서 예측하며, 여기서 e_subj는 subject entity, e_obj는 object entity이다. 앞으로 (e_subj, r, e_obj)를 relation triplet이라고 부를 것이다. 이 entity들은 각 문장 s 내에서 일치하는 span으로 marked 될 것이다. 관계 class에는 30개가 있는데, 이 중 18개는 사람과 관련된 relation, 11개는 organization과 관련된 relation, 나머지 하나는 no_relation이다. 이 class들에 대한 자세한 설명은 Table 10에 나와 있다. 이 모델을 평가할 때에는, micro F1 score(단, no_relation은 제외함)을 사용하고, AUPRC(이건 클래스 30개 모두 포함)을 또한 사용한다.

3.5.1 Data Construction

NER 모델을 사용하여서 거대한 corpora에서 entity pair를 detect 해내고, 그것을 dataset에 추가하는 방식으로 진행한다. 이 방식은 비용 면에서 상당히 효율적으로 거대한 규모의 RE benchmark를 만들어내기 좋다.

그러나, NER 모델이 잘못 예측하면 잘못된 label이 탄생하므로, labeling이 잘못 될 수 있다. 그리고 결과적으로 모델이 서로 연관 있는 label만 고려하므로, RE 모델이 훈련될 때 특정 relation을 과도하게 예측한다. 즉, 실제 관계 class의 분포와 예측을 통해 얻어낸 class의 분포가 다른 문제가 발생하므로, 다른 논문에서는 crowdworker를 고용하여 이 문제를 완화하는 것을 추천한다. 또는 이렇게 과도한 예측을 막기 위해 관련이 없는 entity pair를 의도적으로 추출하는 방법도 소개하고 있다.

Overview

그래서 이 논문의 연구팀에서는 각종 source에서 데이터를 모은 후, crowdworker를 이용해서 올바른 relation을 선택하도록 하고, 이를 자동으로 만들어진 relation과 비교하여 올바르면 바로 사용한다. 그리고 랜덤 샘플링도 진행하여 no_relation의 샘플도 늘린다.

Final Dataset

최종적으로, KLUE-RE dataset은 training data는 32,470개, development set으로는 7,765개, 그리고 test example로는 7,766개로 이루어진다. KLUE-RE에서 문장의 평균 길이는 whitespace를 포함하여 95.9이며, entity type의 비율로는 PER(38.1%), ORG(36.3%), LOC(6.2%), DAT(6.2%), POH(11.9%), NOH(1.3%)이다. 자세한 사항은 Table 11에 나타나있다.

3.5.2 Evaluation Metrics

ㄴㄴ

'Naver BoostCamp AI Tech 3기' 카테고리의 다른 글

| [MRC] 01. MRC Intro & Python Basics (0) | 2022.04.25 |

|---|---|

| BART: Denoising Sequence-to-Sequence Pre-training for NaturalLanguage Generation, Translation, and Comprehension (0) | 2022.03.31 |

| RoBERTa: A Robustly Optimized BERT Pretraining Approach (0) | 2022.03.24 |

| Language Models are Unsupervised Multitask Learners (0) | 2022.03.14 |

| Improving Language Understanding by Generative Pre-Training (0) | 2022.03.10 |